Los inimitables patrones de tu rostro podrán servir hasta para sacar dinero de un cajero automático. Los sistemas de reconocimiento facial están invadiendo eventos, tiendas e incluso iglesias mientras Facebook quiere identificarte incluso cuando no ve tu cara. Pero, ¿cómo sabe quién eres o cómo te sientes un ordenador?

|

Google y Facebook lideran los avances en reconocimiento facial

|

Tu nariz aguileña o chata, tus ojos almendrados o saltones o la propia forma de tu rostro, ovalado o alargado, pueden decir mucho sobre ti a la cámara que en estos momentos tienes enfrente. Windows 10 se ha aprovechado de ello y permite iniciar sesión gracias a su sistema de reconocimiento facial si nuestro ordenador incorpora una cámara Real Sense 3D. No es la única compañía que cree que la biometría de nuestras jetas es el presente y el futuro: Apple ya ha patentado su sistema para que desbloqueemos nuestro teléfono a ritmo de 'selfie'.

Mientras, en todo el mundo comenzamos a observar curiosas (e invasivas) aplicaciones de este reconocimiento: la policía de Reino Unido escaneó los rostros de los asistentes a un festival de música para detectar bandas de crimen organizado sin el permiso de los asistentes, treinta iglesias de todo el mundo utilizan el sistema Churchix para identificar el espejo del alma de los feligreses y en China ya se ha presentado el primer cajero automático que solo nos entrega el dinero si le suena nuestra cara. ¿En qué se fija una máquina para desvelar tu identidad?

|

Página web de la empresa Face-Six, que ofrece reconocimiento facial para eventos

|

ASÍ SABE UNA MÁQUINA QUIÉN ERES

Cada 'software' de reconocimiento facial esconde sus propios secretos, si bien hay una serie de pasos que casi todos siguen, ya sea para identificar sospechosos en los aeropuertos o para que la empresa Face-Six proporcione a los templos información sobre los buenos cristianos.

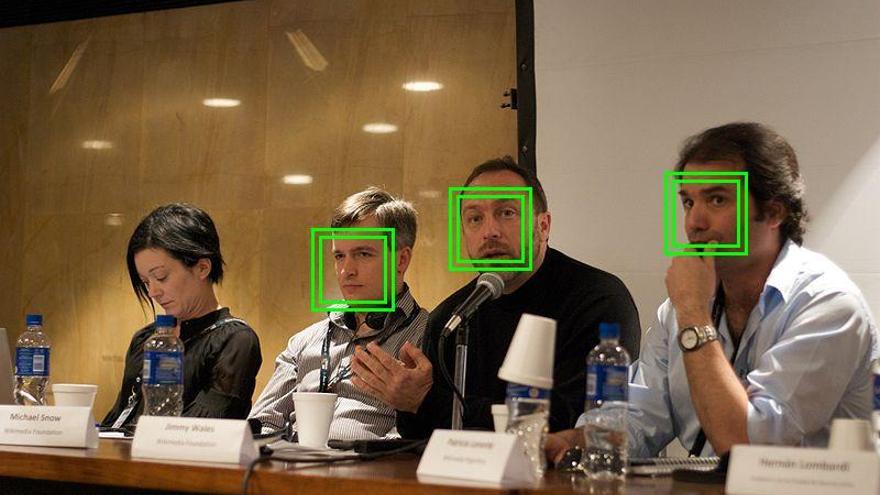

En primer lugar, el sistema tiene obviamente que detectar que somos un ser humano, rastreando los píxeles de la imagen. "Hay algoritmos que, a partir de un conjunto de imágenes que son caras y otro conjunto que no son caras, son capaces de aprender automáticamente a encontrar una cara en una imagen", nos cuenta Pedro Tomé, investigador del Grupo de Reconocimiento Biométrico de la Universidad Autónoma de Madrid.

|

La detección de las caras es el primer paso

|

Según nos explica Enrique Cabello, investigador principal del Grupo de Reconocimiento Facial & Visión Artificial, algunos 'software' se fijan en las características globales de nuestra cara, como la forma (si es más o menos alargada o más o menos redonda) o la configuración general de nuestro rostro (si tenemos una frente muy hundida o unas cejas muy salientes). "Estos sistemas no se fijan en puntos concretos de la cara, sino que toman la fotografía e intentan compararla con la anterior", nos cuenta este experto, que asemeja el sistema con una "lupa" buscando diferencias en nuestro rostro.

Los primeros sistemas de reconocimiento facial comparaban las dos imágenes "en bruto", píxel a píxel, una labor demasiado costosa y poco efectiva, por lo que actualmente nuestra cara se transforma en vectores para reducir la dimensionalidad y extraer la información discriminante de las caras.

|

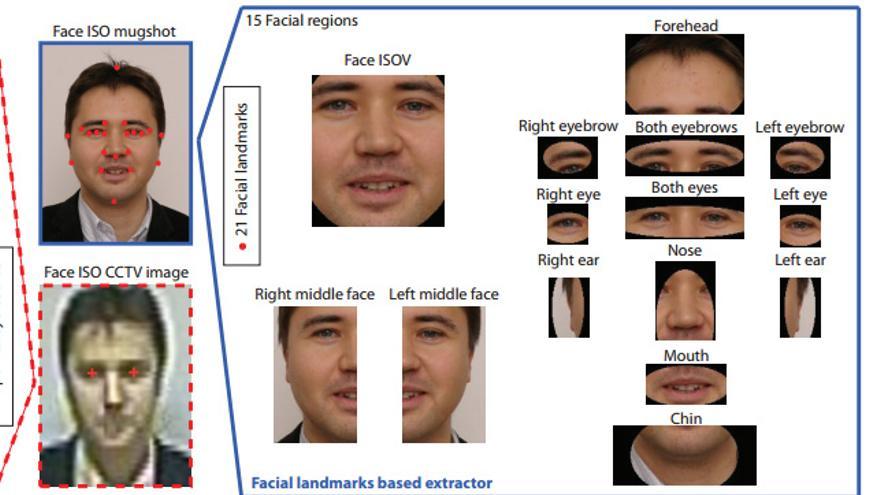

El sistema de reconocimiento puede trazar los puntos faciales para estudiar las diferentes zonas de la cara

|

"A un nivel más alto, los sistemas intentan sacar similitudes, como la distancia entre puntos característicos de la cara, la medida de tu ojo o la distancia del ojo a la nariz", señala Tomé.

Utilizar un modelo 3D de nuestra cara es otra de las alternativas, aunque hay dos opciones distintas: crear un modelo tridimensional de la cabeza del sujeto utilizando varias cámaras o fotografiarle directamente con una cámara 3D. La profundidad permite así mejorar la comparación posterior de las imágenes.

Tomé y Cabello coinciden en que los programas tradicionales combinan diferentes tipos de métodos para extraer tanto características globales como locales, y el color o la iluminación de la escena también se tienen en cuenta. No hay un número específico de datos que se deban extraer para conocer tu fisonomía, aunque Cabello puntualiza que con unos cuantos miles, una máquina ya debería ser capaz de reconocernos.

Una vez extraídas las características o patrones de nuestra cara, el sistema de clasificación (un algoritmo previamente entrenado) busca similitudes con las fotografías de su base de datos. "Cuanto más complicado es el escenario, el rendimiento de los sistemas tiende a bajar", explicaTomé.

"Si me venden un reconocedor facial para hacer el control de los trabajadores de una empresa, éste funcionará siempre con el mismo fondo. En cambio, un sistema comercial en un escenario no controlado, como pueda ser una estación de tren, debe ser mucho más sofisticado, puesto que tiene que hacer frente a un mayor número de casuísticas", detalla este investigador.

|

Cuando el sistema ha estudiado los patrones, compara la cara con su base de datos

|

¿CÓMO SABE UNA MÁQUINA QUE ESTAMOS SONRIENDO?

Además de con fines biométricos, los sistemas de reconocimiento facial también se usan para que una cámara de fotos capte una instantánea cuando percibe que estoy esbozando una sonrisa. Crear un sistema de este tipo es bastante sencillo: tendríamos que fotografiar a 100 o 200 personas en condiciones controladas, pidiéndolas primero que sonrían y después indicándolas que pongan una expresión diferente.

El 'software' solo tendría que buscar la cara, localizarla y analizar las características relevantes (en este caso, los puntos que marcan la comisura de los labios, aunque también podrían analizarse los cambios de posición de las cejas o la aparición de arrugas), para asegurarse de que estamos sonriendo. "Puedo discernir que si la boca tiene una determinada dimensión horizontal y vertical esa persona no está sonriendo o si hay una zona blanca entre los labios", indica Tomé.

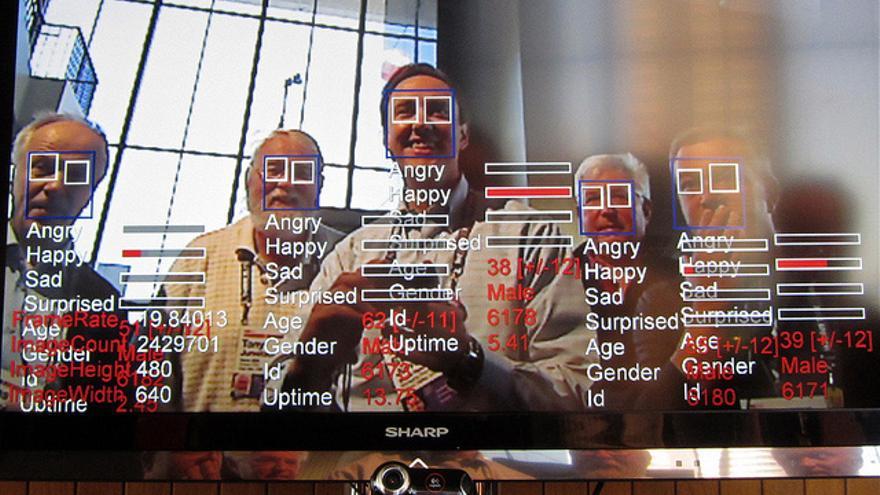

El reconocimiento facial de emociones permite detectar expresiones como alegría, asco, sorpresa, ira o aburrimiento. La compañía Emotient ha entrenado un algoritmo para identificar diferentes expresiones faciales mediante la extracción de 90.000 puntos de interés de cada 'frame' en un vídeo, con el fin de que los comerciantes conozcan cómo se sienten los clientes que recorren sus establecimientos.

ENORMES BASES DE DATOS Y REDES NEURONALES, LA FÓRMULA DE GOOGLE Y FACEBOOK

La mayoría de sistemas comerciales actuales utilizan todavía métodos tradicionales para reconocernos, aunque poco a poco van sustituyendo sus clasificadores por redes neuronales profundas, algoritmos que simulan el proceso que lleva a cabo nuestro cerebro: el propio sistema aprende cuáles son las características que necesita para reconocer a un sujeto y las extrae por sí mismo.

Tres investigadores de Google dieron a conocer recientemente FaceNet, un sistema que han creado entrenando redes neuronales con una base de datos de 260 millones de imágenes. Han conseguido una precisión del 99,63% identificando los rostros de 'Labeled Faces in the Wild', una base de datos que recoge 13.000 imágenes y se emplea para comprobar la eficacia de los sistemas de reconocimiento facial.

Google planta así cara (en un sentido muy literal) a Facebook, que el año pasado presentó DeepFace, capaz de reconocer las imágenes de esa misma base de datos con un 97,35% de precisión, mejorando en un 27% el estado del arte según la compañía. Pero, ¿cómo logró Facebook crear un sistema que distingue las caras casi tan bien como tú?

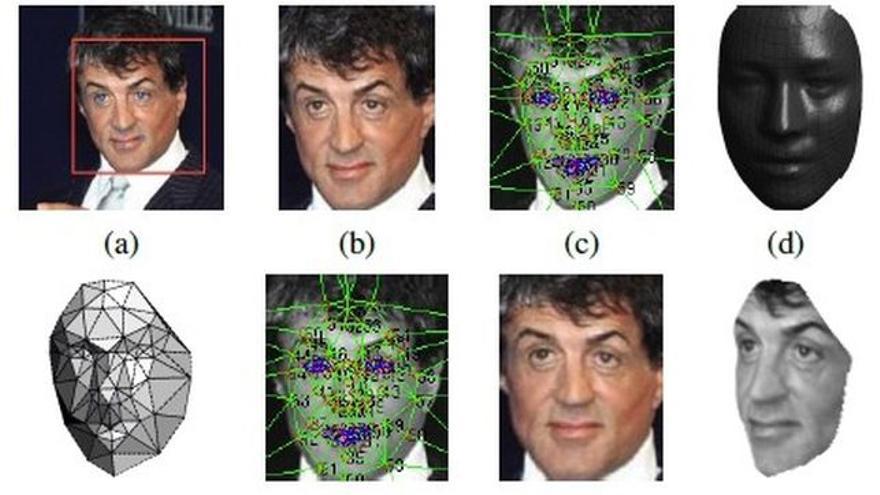

|

DeepFace, el sistema de Facebook que identifica rostros casi tan bien como las personas

|

DeepFace utiliza un modelo en 3D del sujeto para rotar su rostro y que la red neuronal comience a hacer su trabajo, pero el verdadero potencial de su sistema es que entrenaron la red con cuatro millones de fotografías de casi 4.000 personas. "Uno de los secretos de las redes neuronales es siempre la cantidad de datos de entrenamiento y cómo ajustas la infinidad de parámetros", nos cuenta Tomé.

Una compañía con una pequeña base de datos podría tratar de replicar esa red neuronal, pero no va a poder obtener la precisión de DeepFace porque no tiene disponibles tantas imágenes ni el detalle de los parámetros de configuración que ha utilizado, por lo que este investigador califica de "irreproductible" el sistema de Facebook.

La compañía de Mark Zuckerberg ha ido incluso más allá: su laboratorio de inteligencia artificial ha presentado un algoritmo experimental capaz de reconocernos incluso cuando nuestras caras no están visibles en la imagen. Por el momento, han conseguido un 83% de precisión con su sistema utilizando 40.000 fotos públicas de Flickr.

¿Cómo es posible reconocer sujetos de espaldas? "Además de entrenar la red con imágenes de la cara, han relacionado metiendo información complementaria que en principio no es unívoca de la persona", explica Tomé. "Han hecho una prueba reducida. Me gustaría ver un caso real con un montón de imágenes más cómo funciona", puntualiza por su parte Cabello.

EL FUTURO DEL RECONOCIMIENTO FACIAL, A OSCURAS

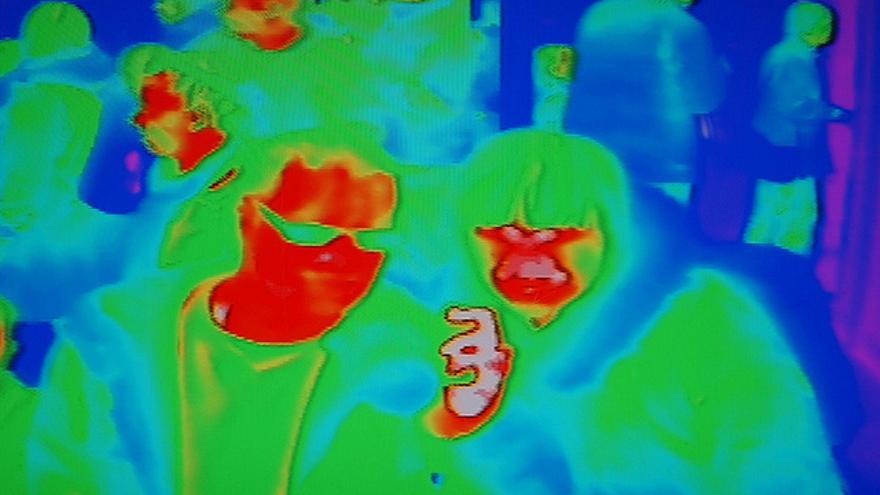

La baja iluminación de las imágenes continúa siendo por el momento uno de los problemas a los que se enfrentan los sistemas de reconocimiento facial tradicionales. Investigadores del Instituto Tecnológico de Karlsruhe acaban de presentar un 'software' que funciona incluso en la oscuridad: una red neuronal profunda compara imágenes infrarrojas con imágenes de luz visible.

Han conseguido un 80% de fiabilidad si disponen de varias fotografías previas del sujeto, y un 55% si solo tienen una imagen con la que comparar en su base de datos. Una tecnología que podría aplicarse en un futuro a las cámaras de videovigilancia.

|

Las imágenes infrarrojas podrían ser la solución para el reconocimiento a oscuras

|

"Si podemos hacer que el reconocimiento facial funcione bien para los gemelos idénticos, debería funcionar bien para la población en general", ha explicado Jeremy Dawson, investigador en biometría de la Universidad de Virginia Occidental, que ha utilizado fotografías convencionales, infrarrojas y también en 3D para tratar de mejorar el 'software' de reconocimiento facial.

"El mejor sistema de reconocimiento de caras es el cerebro", defiende por su parte Cabello. Este investigador cree que nuestra cara no será por el momento la única clave para que un cajero automático nos devuelva nuestros billetes: podrían intentar suplantarnos con una careta exacta de nuestro rostro o bien atacar el propio sistema.

|

¿Invadirán las calles los sistemas de reconocimiento facial?

|

"Imagínate que intercepto tu cara, 'hackeo' el sistema y accedo a la base de datos con todas las caras y puedo hacerme pasar por ti y sacar el dinero de tu cuenta con todos esos números de tu cara", señala este experto en visión artificial. Como la Sala de los Rostros sigue siendo un lugar del universo ficticio de 'Juego de Tronos', cambiar una contraseña es aún bastante más fácil que sustituir nuestro semblante.

Precisamente por eso, el reconocimiento facial se utilizará de forma conjunta con otras técnicas biométricas como la biometría de voz. "Creo que estará incluido, pero entrará en el mercado poco a poco, como otro complemento más", señala Tomé.

Eso sí, aunque nuestra cara combinada con nuestra huella dactilar o con nuestros patrones vocales vaya a sustituir progresivamente a nuestras inseguras contraseñas, la preocupación por la privacidad de los datos sobre nuestra fisonomía será uno de los grandes dilemas de los próximos años. Al fin y al cabo, ¿de qué me sirve a mí que Facebook sea capaz de reconocerme incluso si trato de esconder mi rostro?