Como una máquina del tiempo, introduce un retardo de hasta 15 segundos para darnos imágenes estables pero no exactas

MADRID

MALEN RUIZ DE ELVIRAenlace

En muchas retransmisiones en directo la emisora introduce un pequeño retardo que le permite tener capacidad de reacción ante imprevistos importantes. Aunque no sea lo mismo, el cerebro también gestiona la información que llega a nuestros ojos para ofrecernos una síntesis estable con retraso de hasta 15 segundos, concluyen unos investigadores.

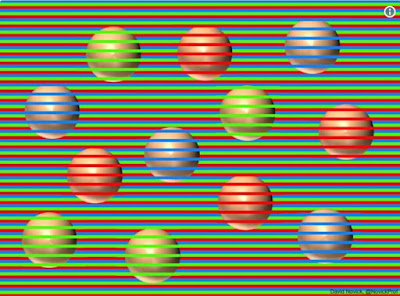

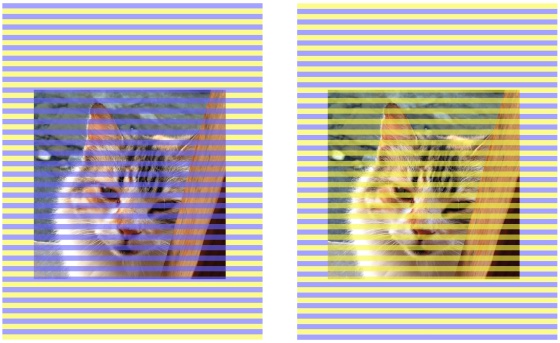

¿Si los estímulos visuales que recibimos varían continuamente, sin orden ni concierto, por qué la percepción que tenemos, el resultado de lo que vemos, no es caótico sino notablemente estable? Es lo que se han preguntado unos científicos (y muchos otros antes que ellos) y han llegado a la conclusión de existe un mecanismo cerebral activo de estabilización, una ilusión visual que se basa en refrescar cada 15 segundos en vez de continuamente las imágenes que llegan a nuestros ojos para componer un resultado final suavizado y coherente sin esfuerzo por nuestra parte.

Así, la información visual de un objeto en cambio constante se funde a lo largo del tiempo hasta darle una estabilidad ilusoria que nos lo representa en un momento del pasado, explican los científicos en la revista Science Advances. Definen el cerebro como una máquina del tiempo que nos manda constantemente al pasado.

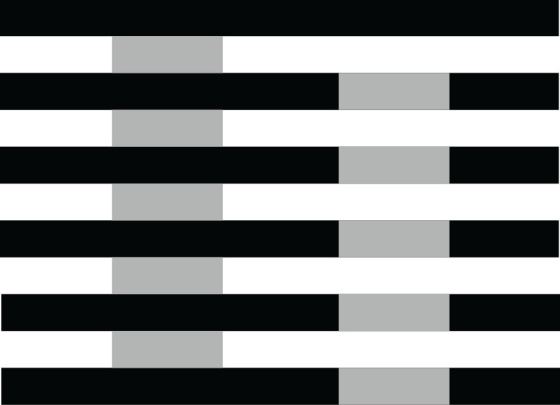

"Por un lado, el mundo visual se altera continuamente por cambios en la luz, el punto de vista y otros factores", explican los autores en The Conversation. "Por el otro la información visual que nos llega cambia constantemente debido al parpadeo y a los movimientos de nuestros ojos, cabeza y cuerpo" señalan Mauro Manassi, de la Universidad de Aberdeen y David Whitney, de la de California en Berkeley.

Este batiburrillo variable de información es fácil de comprobar si vamos grabando con un móvil hacia delante mientras andamos y miramos también en otras direcciones. En una situación más estable no se perciben las fluctuaciones y el ruido visual que nos rodea y que es lo que llega a los ojos, pero no lo que creemos ver.

El cerebro, creen los investigadores, en vez de analizar todas y cada una de las instantáneas, hace que percibamos la media de lo que vimos en los últimos 15 segundos, lo que no nos deja notar cambios sutiles pero también nos permite funcionar en la vida diaria. De otra forma, sentiríamos estar en una alucinación constante.

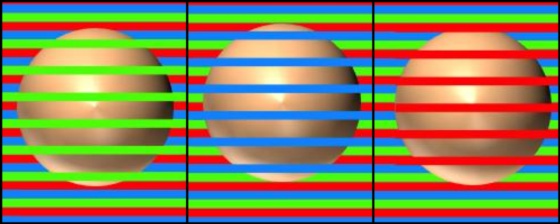

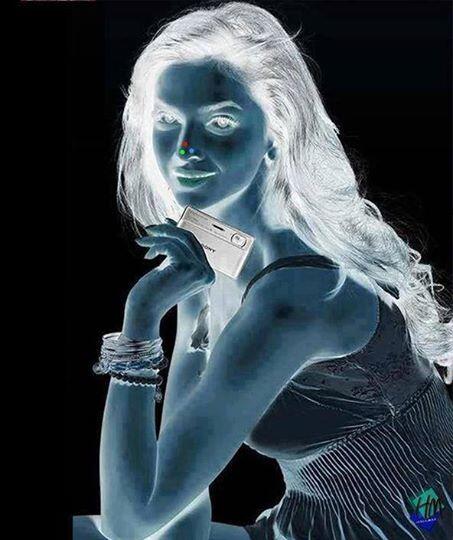

Para llegar a esta conclusión, los investigadores realizaron varios experimentos complicados con centenares de voluntarios. Algunos vieron un video de imágenes de caras que envejecían o rejuvenecían a lo largo de 30 segundos. Cada participante valoraba una sola vez la edad final del vídeo. En general estimaron que el cambio era mucho menor que el real.

Comparada con la edad estimada por otros participantes de las caras de referencia (la de la persona mayor y la de la persona joven), dieron como media una edad cinco años menor para la imagen final del que envejecía y una cinco años mayor para el que rejuvenecía, como si estuvieran viendo la imagen de la mitad del video, a los 15 segundos, y no la final.

Además de varios experimentos más de este tipo repitieron algunos añadiendo ruido sonoro variable y comprobaron que el ruido ambiente altera la percepción visual llevándola todavía más al pasado.

Estos investigadores no creen que el que ellos describen sea el único mecanismo existente para la ilusión perceptiva de estabilidad de la visión (se han sugerido y estudiado otros) y piensan que reciclamos información del pasado porque es más eficiente, más rápido y da menos trabajo al cerebro.

"Nuestro sistema visual a veces sacrifica la exactitud para lograr una experiencia visual fluida del mundo que nos rodea", aseguran. Sin embargo, alertan de los efectos negativos del retardo con que procesa el cerebro.

Sin embargo, alertan de los efectos negativos del retardo con que procesa el cerebro. Puede, por ejemplo, dar lugar a equivocaciones cuando se ven muchas imágenes distintas muy seguidas, como sucede al analizar radiografías médicas para hacer diagnósticos.

Por otra parte, no es el único caso en el que pesa el pasado porque, como recuerdan, nuestras decisiones cotidianas en cualquier situación siempre e inevitablemente están influidas por nuestra experiencia anterior.